El archivo robots.txt puede ser un gran aliado a la hora de mejorar el SEO de tu web.

Me explico.

Aumentar el tráfico de una página web para llegar a más clientes potenciales es uno de los objetivos más habituales hoy en día.

Para ello, existen profesionales que se dedican exclusivamente a la creación de contenidos y al desarrollo de estrategias de posicionamiento web.

Porque, ¿de qué sirve crear una gran cantidad de contenido si después no lo ve nadie?

Sin embargo, esto no quiere decir que todo el contenido que alojes en tu página deba ser crawleado por los rastreadores de los motores de búsqueda. Y es en este punto en el que el archivo robots.txt juega un papel fundamental.

En este artículo, ahondaremos en los siguientes temas:

- ¿Cómo rastrea Google el contenido de tu web?

- ¿Qué es el archivo robots.txt?

- ¿Por qué no debes rastrear todo el contenido de tu página web?

- ¿Para qué sirve el archivo robots.txt? Principales funciones

- Sintaxis del archivo robots.txt

- ¿Cómo crear un archivo robots.txt?

¡Vamos a ello!

*Artículo con contenido actualizado en 2022

¿Cómo rastrea Google el contenido de tu web?

Google rastrea las páginas de manera periódica en búsqueda de nuevos contenidos a través de sus robots -también conocidos como arañas, crawlers o rastreadores web de Google-.

Una vez detecta estos nuevos contenidos, los analiza y los indexa.

El archivo robots.txt -ahora quizá hayas adivinado de dónde proviene su nombre- tiene un papel muy relevante en el crawleo de las páginas web.

Además del Googlebot, otros crawlers también pueden acceder a tu página. Por ejemplo, Yahoo_Slurp, Msnbot (perteneciente a Bing). Su proceso es el mismo: rastrear nuevos contenidos, valorarlos e indexarlos.

¿Qué es el archivo robots.txt?

El archivo robots.txt -anteriormente conocido como protocolo de exclusión de robots- es un archivo de texto que se coloca en la raíz del sitio web.

Este archivo público le indica a los robots de búsqueda qué páginas dentro de tu web deben rastrear. Y, también, les informa de aquellas a las no deben acceder.

Aunque, a priori, es un archivo desconocido por gran parte de los usuarios, de manera general todas las páginas web tienen uno.

Para comprobar cómo es el de tu web, basta con que escribas en tu navegador la dirección de tu página y, al final de la misma, “/robots.txt”.

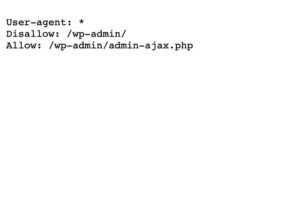

De esta manera, obtendrás un resultado parecido a este:

Como ves, es un archivo de texto plano que se coloca en la carpeta raíz de tu web.

Habitualmente, las empresas centran sus esfuerzos en crear contenido interesante para su target e intentan posicionarlo en las primeras posiciones de los resultados de los motores de búsqueda.

Los profesionales del posicionamiento mejoran la calidad del sitio web y optimizan estos contenidos, de manera que Google pueda rastrearlos, valorarlos e indexarlos.

Por eso, resulta chocante en un primer momento que haya cierto contenido de tu web que no interese ser rastreado, ¿verdad?

¿Por qué no debes rastrear todo el contenido de tu página web?

El rastreo de una página web -en caso de que el archivo robots.txt diga lo contrario- se produce en todas y cada una de las páginas.

Por ello, si tu web contiene muchas páginas puede verse afectada por el crawl budget -o presupuesto de rastreo-.

El crawl budget hace referencia a la cantidad de URL que un GoogleBot puede rastrear de una página web.

Es decir, que el bot no rastrea tu página por completo: solo una parte de los contenidos de la misma -que, posteriormente, serán indexados-.

Esta es una problemática que afecta, sobre todo, a ecommerce con un amplio catálogo de productos o a webs que publican un alto volumen de contenidos diarios. Por ejemplo, un periódico online.

Por lo tanto, es importante clarificar en qué parte de tu contenido quieres que invierta su tiempo el bot de Google. Es decir: qué páginas son, a tu parecer, las más valiosas de cara a tu posicionamiento.

Y es en este punto de incluir las URLs concretas de tu sitio que son las más relevantes donde entra en juego el archivo robots.txt.

¿Para qué sirve el archivo robots.txt? Principales funciones

Los expertos en posicionamiento emplean este archivo con tres objetivos diferentes:

- Bloquear el acceso de los rastreadores de los motores de búsqueda a determinadas páginas de la web.

- Optimizar el crawl budget, dando prioridad al contenido de importancia y eliminando problemas derivados de tener contenido irrelevante o duplicado. También es útil para restringir crawleo de paginaciones o subdirectorios, si así se requiere -debes recordar que cada caso es diferente-.

- Indicar de manera sencilla dónde se encuentra el sitemap.

De igual manera, debes tener en cuenta que el archivo no es infalible. Y es que, que un contenido no sea rastreado, no significa que no sea indexado.

Es decir, que una página puede ser indexada si recibe enlaces entrantes.

Por ello, si lo que se quiere es desindexar una página para que no se muestre en los resultados de búsqueda, debes incluir la metaetiqueta robots “no index” -evitando restringir su acceso en el archivo robots.txt-.

Sintaxis del archivo robots.txt

A continuación, vamos a explicar el conjunto de comandos empleados dentro del archivo robots.txt según las preferencias de optimización.

Así, podrás crear un archivo optimizado para los rastreadores de los motores de búsqueda.

User-agent o agente de usuario

User-agent -o agente de usuario- es el comando empleado para dar órdenes específicas a un determinado motor de búsqueda.

Por ejemplo, para dar una orden específica al robot de Google (Googlebot), tendrías que incluir el siguiente comando:

User-agent: Googlebot

En caso de que quieras que todos los robots sigan dicha orden, deberás añadir un asterisco. Es decir, que quedaría de la siguiente manera:

User-agent: *

El comando Disallow

Este comando da una orden de qué parte del contenido no debe rastrear el robot del motor de búsqueda. Para ello, emplearemos el comando disallow de la siguiente manera:

- Para bloquear toda la página, añadiremos:

Disallow: /

- Para bloquear un contenido en concreto, añadiremos la URL de una página de tu sitio seguida de la barra inclinada. Por ejemplo:

Disallow: paginadeejemplo.com/directorio/post-del-blog

También se puede restringir el rastreo de una imagen, e incluso facilitar el rastreo de un determinado contenido.

La orden contraria a esta directriz sería el comando Allow, que se emplearía de la misma manera que su homónimo y daría acceso a las páginas especificadas.

Por último, es habitual indicar dónde se aloja el sitemap y, a la hora de optimizar el SEO, indicar el comando Crawl-delay. Este último aporta instrucciones al bot sobre el tiempo de cara entre cada página -algo habitual a la hora de mejorar la velocidad de carga del servidor-.

¿Cómo crear un archivo robots.txt?

Si todavía no tienes un archivo robots.txt para tu página web, puedes crear uno con un editor de texto.

Es muy sencillo: se trata de un archivo de texto plano que debes guardar en formato .txt.

Escribe una a una las directivas que hemos visto anteriormente, optimizando tu contenido para los motores de búsqueda.

De igual manera, si tienes alguna duda puedes emplear las establecidas por los rastreadores web de Google. Puedes verlas aquí.

Además, algunos plugins como Yoast permiten realizarlo de manera automática.

Por último, puedes comprobar si el archivo robots.txt está funcionando correctamente y está bloqueando el acceso de los rastreadores de los buscadores a algunas páginas concretas o si, por el contrario, presenta algún error. Puedes hacerlo a través de Search Console.

¿Ya sabes cómo crear un archivo robots.txt para tu web?

Como ves, optimizar el archivo robots.txt puede serte muy útil a la hora de mejorar el rendimiento de tu página en los motores de búsqueda.

Eso sí: siendo consciente siempre de la dimensión de tu sitio web y de sus necesidades.

Emplea las herramientas que hemos descrito anteriormente para verificar que tu archivo robots.txt no tiene error alguno y monitoriza tus resultados.